近期JD放货了,使用国补买了顶配的128GB内存配置的幻X 2025。 在年初就听说AMD这款向Apple致敬的CPU,之前量很少,等待了半年终于到手了,(不要问为什么不买Mac M3或M4,就是不喜欢

目前就到手一周,机子本身还可以,全机身CNC工艺还可以,感觉很厚重,比我手里的Thinkpad X1 Tablet 2,Huawei Matebook e 都厚50% 以上。**必须严重吐槽一下这款ROG星云品目面板的质量,左右边框10毫米的区域内,背光亮度会偏暗一些,在白色背景的时候,会非常非常让人不爽快。

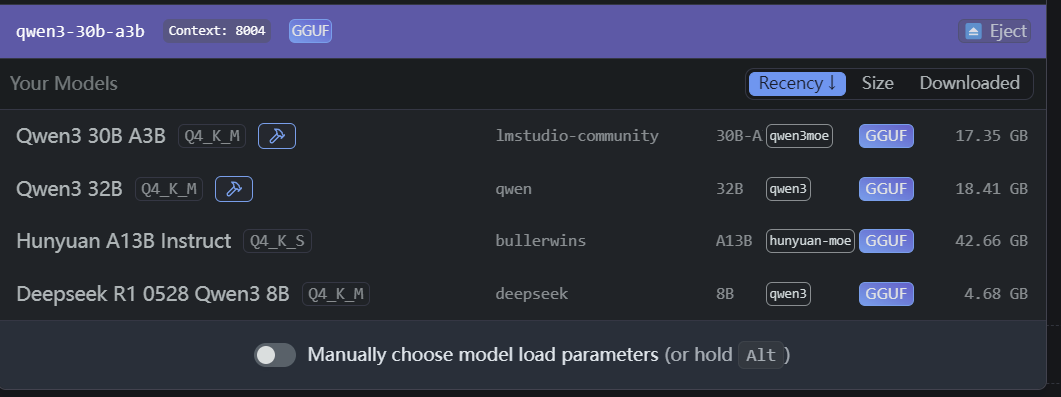

安装LM Studio,替换国内源,折腾下来,目前就下了这几个模型:

| 模型名称 |

速度 |

使用体验 |

| Qwen3 30B A3B |

40 tokens/s |

可接受 |

| Qwen3 32B |

8-10 tokens/s |

较低 |

| Hunyuan A13B Instruct |

未支持(需自行编译lm-studio) |

- |

| Deepseek Qwen3 8B |

28 tokens/s |

可接受 |

AMD 395+ GPU算力较弱(等效4060),内存带宽为256Gb/s。 我查了一下Mac家的相关内存带宽性能。

| 芯片型号 |

内存带宽 |

说明 |

| M3 Ultra |

800Gb/s |

最高性能 |

| M3 Max |

400Gb/s |

高端机型 |

| M4 Pro |

270Gb/s |

接近AMD 395+带宽 |

为什么要谈到内存带宽呢,因为LLM的token生成速度跟显存/内存的带宽有很大关系,容量大小只决定你能否加载LLM,跑起来的速度则直接与带宽相关。

从youtube上的一个评论上看到,

To generate a token, you need to complete a forward pass through the model, so (tok/s) * (model size in GB) = effective memory bandwidth

这个评价不是非常精确,但可以快速评估LLM在本地的运行效果。 公司同事用M4 Pro 48GB内存版本跑大模型的性能就比我快一丢丢,差距不明显。

综合体验下来,适合395+ 的应该是MOE模型,模型原始尺寸可以比较大,充分利用高达96GB的可用显存,激活时使用8B-16B的参数,那么就有可以接受的token生成速度,同时有较好的使用体验。(当然希望MOE不要有负优化)