前言

官方的博客也介绍了接入的方法,不过这个博客是海外的,因此其中的 URL 是不适用我们国内用户的,但是大家可以参考一下其中提及的一些工具,比如魔改后的 Qwen Code(从 Gemini CLI 魔改而来):

【Qwen3-Coder: 在世界中自主编程

https://qwenlm.github.io/zh/blog/qwen3-coder/】

接下来将介绍一些常用的接入方法。

魔搭方式接入

注意事项:如果你没有什么其他的需求的话,强烈推荐你从魔搭开始,而不是使用百炼。后者虽有免费的 1M 额度,但是已经有不少朋友被反薅了,魔搭则是按次的,每日免费 2k 额度,开通了直接就可以调用不需要部署。用量在右上方头像那里,鼠标悬浮在头像上面,就会弹出菜单,然后最下面就会显示用量情况>

使用前检查你的密钥:魔搭的api key复制有bug,在某些情况下(具体没测试出来)会在key的开头增加:ms- 导致整个key就错了,如果这时候查看一下发现复制的和实际显示根本不是一个key,复制的多了东西。所以,各位如果怎么配魔搭的api发现都报401,可以看看自己的key是不是复制对了。

通过 NewAPI 中转

为什么推荐用 NewAPI 中转?从我个人角度出发,是因为能够让我统一管理我的各种模型,而且可以随时方便进行组合式模型接入(比如配合 CCR 项目实现一个 URL 和秘钥,定义大小任务模型等)

在新建渠道的时候,类型选择 OpenAI,然后魔搭平台的请求 URL 为:

https://api-inference.modelscope.cn

密钥的获取方式如下:

首先要有个阿里云账号,然后去这里登录注册一下,绑定自己的阿里云账号(给出的链接就是 Qwen-Coder 模型地址):

魔搭社区:https://modelscope.cn/models/Qwen/Qwen3-Coder-480B-A35B-Instruct/summary

然后页面右侧的 查看代码范例中复制自己的 api_key即可。

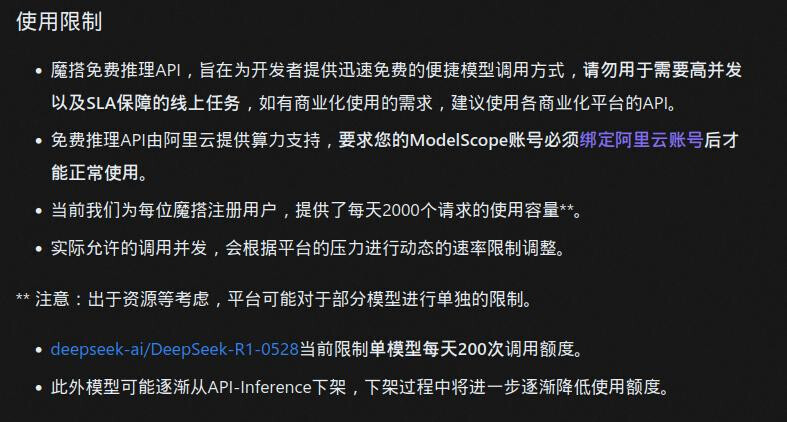

注意的是,魔搭平台的免费模型有一定的使用限制,不过对于个人使用还是足够的了

再一次提示

使用前检查你的密钥:魔搭的api key复制有bug,在某些情况下(具体没测试出来)会在key的开头增加:ms- 导致整个key就错了,如果这时候查看一下发现复制的和实际显示根本不是一个key,复制的多了东西。所以,各位如果怎么配魔搭的api发现都报401,可以看看自己的key是不是复制对了。

模型的名称填写为:

Qwen/Qwen3-Coder-480B-A35B-Instruct

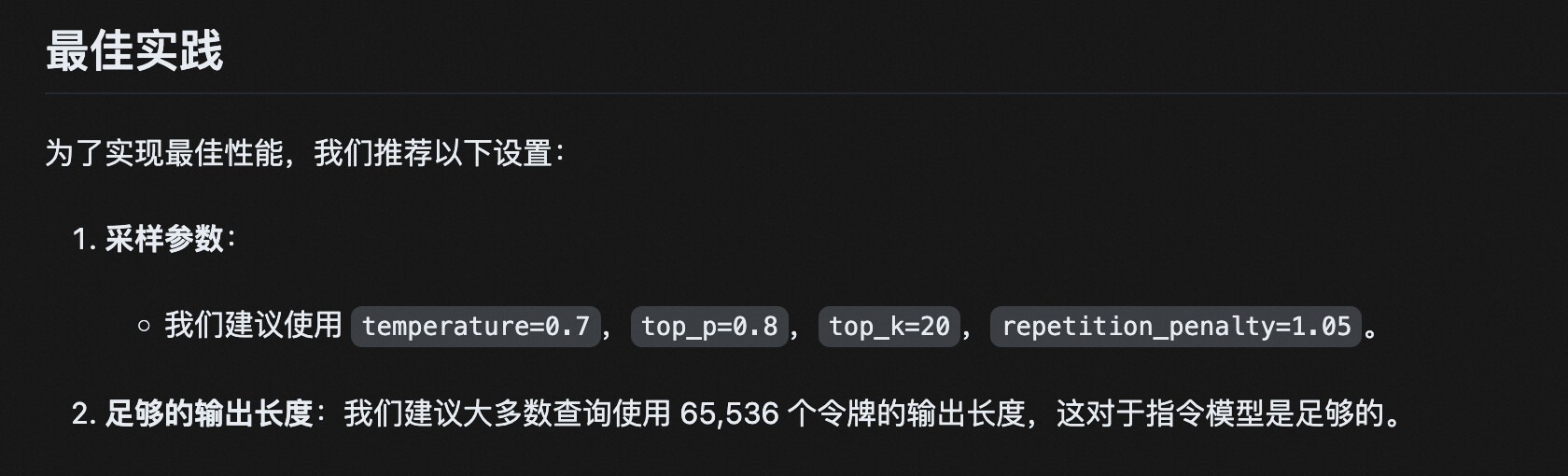

并且通过 NewAPI 聚合还可以实现参数覆盖的功能。官方建议如下:

那么我们可以在添加渠道的时候,通过参数覆盖添加实现:

不过,我个人不太清楚覆盖参数的语法是否正确,我没有进行验证,如觉得有问题,恳请指正,JSON 内容如下:

{

"temperature": 0.7,

"top_p": 0.8,

"top_k": 20,

"repetition_penalty": 1.05

}

这样,我们便在自己的 NewAPI 中添加了属于自己的模型,如何使用便不在此赘述了

间接接入 Claude Code

需要再次强调的是,魔搭的接口是 OpenAI 的格式的,这意味着是无法直接接入到 Claude Code 中去的,需要使用 Claude Code Router 项目来进行转换。

项目地址如下:https://github.com/musistudio/claude-code-router/blob/main/README_zh.md

在根据项目文档,安装好 Claude Code 和 Claude Code Router 之后,我们需要在自己的家目录下创建一个配置文件 ~/.claude-code-router/config.json。这个配置文件是全局生效的。

一个直接连接魔搭社区的配置文件参考模板如下:

{

"Providers": [

{

"name": "modelscope",

"api_base_url": "https://api-inference.modelscope.cn/v1/chat/completions",

"api_key": "xxxx",

"models": ["Qwen/Qwen3-Coder-480B-A35B-Instruct"],

"transformer": {

"use": [

[

"maxtoken",

{

"max_tokens": 65536

}

]

]

}

}

],

"Router": {

"default": "modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct"

},

"HOST": "127.0.0.1",

"LOG": true

}

只需要修改其中的密钥为你之前获取到的,便可以在你的项目根目录通过 ccr code 命令启动进行对话了。

如果你采用了和我一样的 NewAPI 聚合法,可以调整的选择更多一些,能够自由定义大小模型。我自己的最简配置如下:

{

"LOG": true,

"Providers": [

{

"name": "newapi",

"api_base_url": "https://xxx.xyz/v1/chat/completions",

"api_key": "sk-xxx",

"models": ["Qwen3-Coder-Instruct-MD", "GPT-4.1", "GPT-4o", "DeepSeek-R1-HuoShan"]

}

],

"Router": {

"default": "newapi,Qwen3-Coder-Instruct-MD",

"background": "newapi,GPT-4o",

"think": "newapi,DeepSeek-R1-HuoShan",

"longContext": "newapi,Qwen3-Coder-Instruct-MD",

"webSearch": "newapi,Qwen3-Coder-Instruct-MD"

}

}

将其中的 xxx 内容换成你的 NewAPI 服务器的域名地址,密钥也修改为你创建的密钥即可。也不要忘记修改模型,在 models 中填写好你的调用的模型的实际名字(我做了模型重定向,因此我的模型名称自定义程度很高),并且将最后的 Router 中的各种模型修改好(细节见 Claude Code Router 项目文档,在此处便不多赘述了)即可。

直接接入 Roocode、Cline、Kilocode 等插件

因为魔搭的 URL 是 OpenAI 兼容的,这意味着我们可以很方便地直接将其及接入到我们的插件中去,而仅仅只需要做一点点修改。

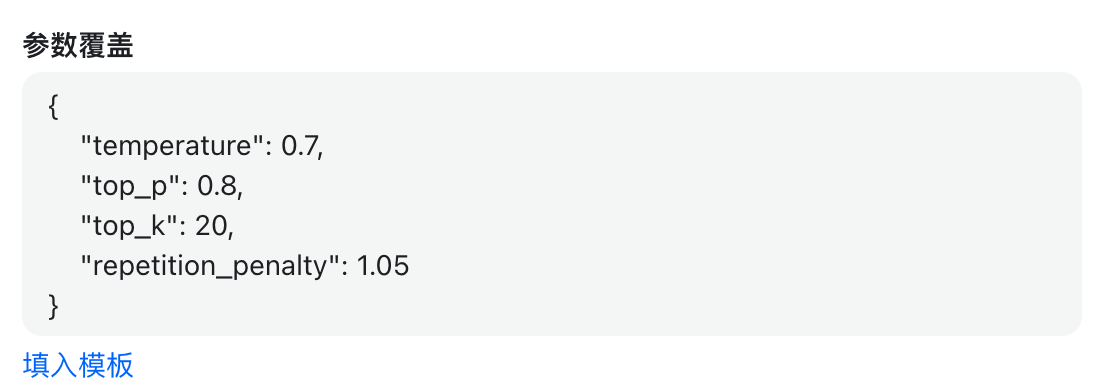

- 供应商选择 OpenAI 兼容(也就是 OpenAI Compatible)

- Base URL 填写:https://api-inference.modelscope.cn/v1

- API KEY 填写你从魔搭社区创建的密钥(不是 NewAPI 密钥哦!)

- Model 填写:Qwen/Qwen3-Coder-480B-A35B-Instruct

- 不支持图片输入

- 下面的 Context Windows Sizes 写 262000 即可

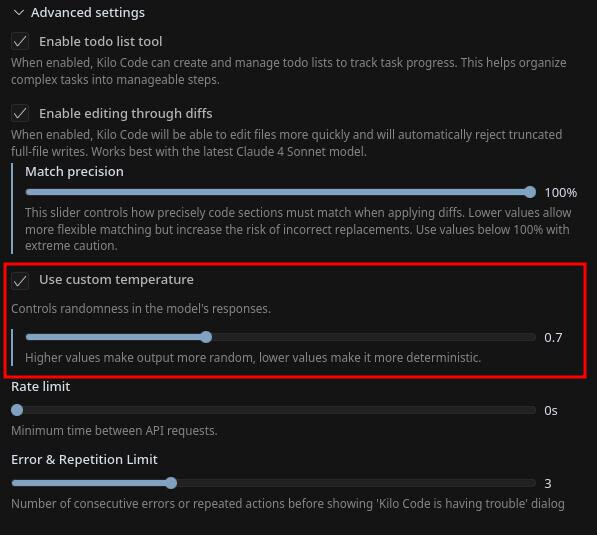

- 模型温度(temperature)选择 0.7

图示

这样,便可以开始使用了。

通过 Qwen Code 直接接入

这个方法也是从官方博客看到的。官方说到:

Qwen Code 支持 OpenAI SDK 调用 LLM,你可以导出以下环境变量,或者简单地将其放在 .envfile 中。

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

因此可以认为,Qwen Code 原生支持 OpenAI 格式接口接入,所以只要将其中的 URL 修改为魔搭或者你的 NewAPI 的 URL,写到 /v1 即可。密钥也修改为对应平台的密钥,模型名称同理,.env (官方博客笔误为 .envfile,需注意)配置文件默认放在家目录下,然后便可以开始使用了。

什么是 Qwen Code 呢?官方介绍说:

Qwen Code 是一个 CLI 工具,修改自 Gemini CLI,针对 Qwen3‑Coder系列的模型增强了解析器和工具支持。

确保已安装 Node.js 20 及以上版本,可以通过以下命令安装:

curl -qL https://www.npmjs.com/install.sh | sh

然后通过 npm 管理器安装 Qwen Code:

npm i -g @qwen-code/qwen-code

另一种方式是从源码安装:

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code && npm install && npm install -g

最后, 可以通过简单地输入 qwen 来享受 Qwen-Code 和 Qwen 带来的编程体验。

百炼方式接入

再次强调:如果你没有什么其他的需求的话,强烈推荐你从魔搭开始,而不是使用百炼。后者虽有免费的 1M 额度,但是站内已经有不少朋友被反薅了,魔搭则是按次的,每日免费 2k 额度,开通了直接就可以调用不需要部署。用量在右上方头像那里,鼠标悬浮在头像上面,就会弹出菜单,然后最下面就会显示用量情况

百炼直接接入 Claude Code

从官方博客可以知道,百炼是支持直接接入到 Claude Code 中使用的,官方提供了dashscope上的接口转换。我们使用的请求地址为:

https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy

如果上面的地址还是用不了,那么可能是因为没有开通服务,详情可以移步至官方文档:

通义千问API参考 - 大模型服务平台百炼 - 阿里云:https://www.alibabacloud.com/help/zh/model-studio/use-qwen-by-calling-api

将 API KEY 也换成百炼获取的 KEY(上面文档开通获取):

export ANTHROPIC_BASE_URL=https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=your-dashscope-apikey

然后直接使用 Claude Code 即可

百炼直接接入插件

和之前的魔搭同理,只要填入正确的 URL、模型名称等即可,其中模型名称应为:qwen3-coder-plus

百炼的其他用途

有了 URL 和 KEY,接入方式和先前的魔搭大同小异,因此不多赘述,只要看好自己的钱包即可

最后

通过 Claude-code-router 的方式接入的,速度真的很不错,响应速度也快,工具调用也是丝滑,目前没有出现工具调用失败的情况,而且可以和 IDEA 或者 VSCode 的 Claude Code 插件搭配使用,修改的时候可以直接定位到修改文件(效果也是不错的,听我同学说,基本都是一次改对什么的)

还是值得大家尝试的。趁现在还没有什么人知道,爽用起来吧

补充

然后再补充一个在 Windows 下给 Claude Code 添加 Context7 的 MCP 的命令(需要你的 CMD 能够识别到 node 环境,我没有给出 powershell 的了……因为我自己是 MacOS):

claude mcp add context7 -- cmd /c "npx -y @upstash/context7-mcp@latest"

命令执行完毕之后,启动 Claude(或者用 ccr code 启动),然后使用 /mcp 命令就可以看到加载出来的 MCP 了

其他的 MCP 添加方式大同小异,大家可以自行摸索一下