大家好啊~好消息来了!现在你只需要 170GB 内存,就能在本地跑咱们最新的 DeepSeekV3.1 终端版模型了!🐋

这个“终端”可不是普通升级,它在工具调用和代码生成这块儿比原版 V3.1 强太多了,可以说是全面进化!

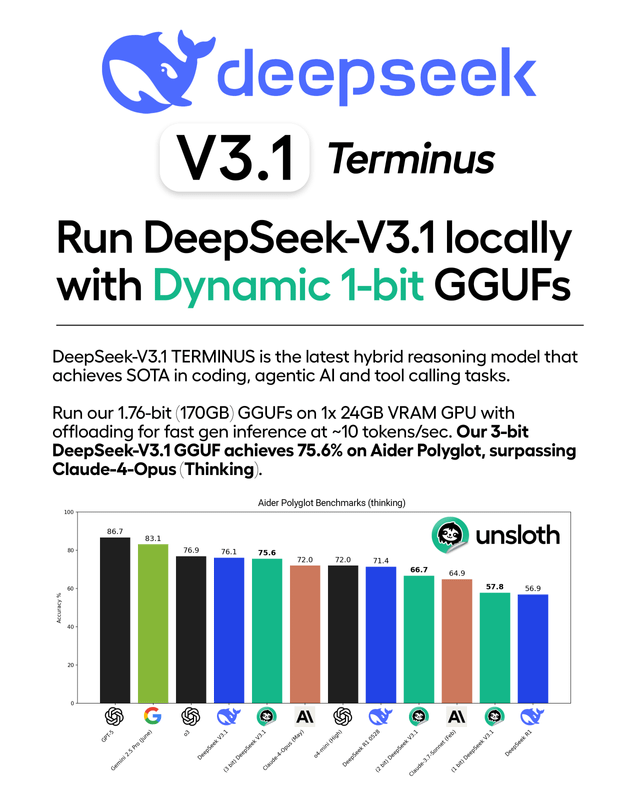

重点来了:我们做的动态量化 GGUF 版本表现超猛!比如这个 3bit 的 Unsloth DeepSeekV3.1(思维模式)GGUF,在 Aider Polyglot 测试里直接干到了 75.6% 的得分——连 Claude4Opus(思维版)都被它超过了!是不是有点东西?详细的实验结果我们都写进博客里了。

👉 终端版 GGUF 模型下载地址:

https://huggingface.co/unsloth/DeepSeekV3.1TerminusGGUF

我们用了超聪明的层量化技术,把原本高达 715GB 的大模型压缩到了 170GB,整整小了 80%!但性能几乎没缩水。你可以用 llama.cpp 跑任意精度版本,包括全精度模型。

特别贴心的是,我们也做了适配 Ollama 的版本(约 162GB),只要这么一行命令就能跑起来:

OLLAMA_MODELS = unsloth_downloaded_models ollama serve &

ollama run hf.co/unsloth/DeepSeekV3.1TerminusGGUF:TQ1_0

📌 教程和更多细节看这里:

https://docs.unsloth.ai/basics/deepseekv3.1

感谢大家支持!快去试试看吧,跑得咋样一定记得告诉我们哈~😊

|