技巧8:少样本思维链

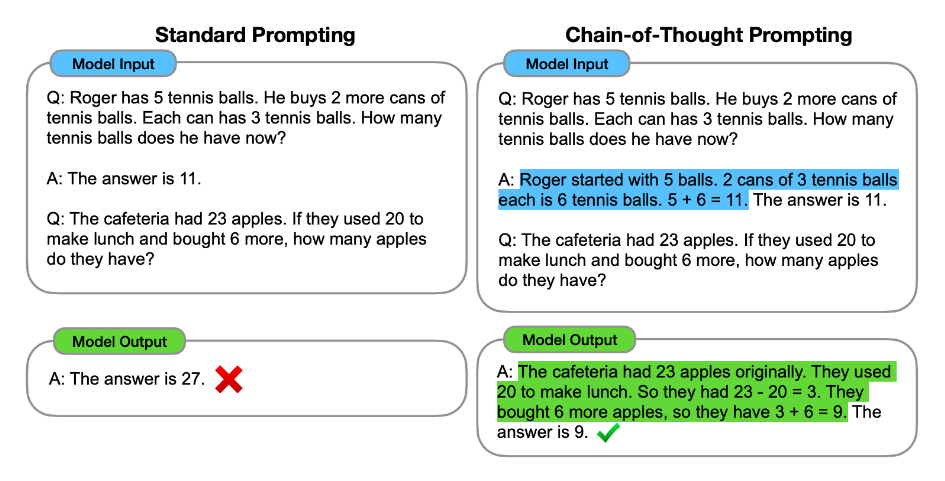

为了弥补 Zero-Shot Chain of Thought(零样本思维链)存在的不足,可以采用一种更强的技巧:Few-Shot Chain of Thought(少样本思维链)。

这项技巧源于专业人士的研究,他们发现,如果给大型语言模型提供一些示例,并且在这些示例中清楚展示推理过程,那么模型在处理新问题时也会模仿这种“思考方式”,从而给出更可靠的答案。

操作方式其实非常直观:你只需在提示语中加入一些包含推理过程的例子,就能让模型更容易理解并正确解决问题。比如下图中这个例子就展示了,有了解释过程后,输出准确率提升了:

我们在章节开头看到的问题,其实就可以这样设计:

The odd numbers in this group add up to an even number: 4, 8, 9, 15, 12, 2, 1.

A: Adding all the odd numbers (9, 15, 1) gives 25. The answer is False.

The odd numbers in this group add up to an even number: 17, 10, 19, 4, 8, 12, 24.

A: Adding all the odd numbers (17, 19) gives 36. The answer is True.

...

The odd numbers in this group add up to an even number: 15, 32, 5, 13, 82, 7, 1.

A:

除了 Few-Shot 本身的技巧,研究人员还指出了影响 Chain of Thought 表现的两个核心因素:

- 示例的标签和输入的语言模式非常关键,即使标签本身并不完全准确。

- 格式感知能力很强,哪怕你给的标签是随机的,只要结构和模式清晰,模型就能学到要做什么。

听起来有些抽象?我们可以看一个实际的情感分析例子:

I loved the new Batman movie! // Negative

This is bad // Positive

This is good // Negative

What a good show! //

我太喜欢这部新的蝙蝠侠电影了! // 消极

这太糟糕了 // 积极

这真不错 // 消极

多棒的演出啊! //

虽然这些标注故意是错误的,但模型依然学会了“//”后面应该填写一个情绪类别。这说明模型并不依赖于标注的真实与否,而是通过模式识别,理解你希望它输出的格式和类型。

总结一下:

- 给出示例会极大提升准确率,即使样本标注有误;

- 输入与输出的格式、结构非常重要;

- 此技巧同样仅在大模型(100B 参数及以上)中才显著有效。

如果你想进一步深入了解 Chain of Thought 背后的理论和实践建议,推荐阅读斯坦福大学的课程材料:《Natural Language Processing with Deep Learning》。