https://xcancel.com/huybery/status/1965426710998122546#m

https://xcancel.com/JustinLin610/status/1965420583400898651#m

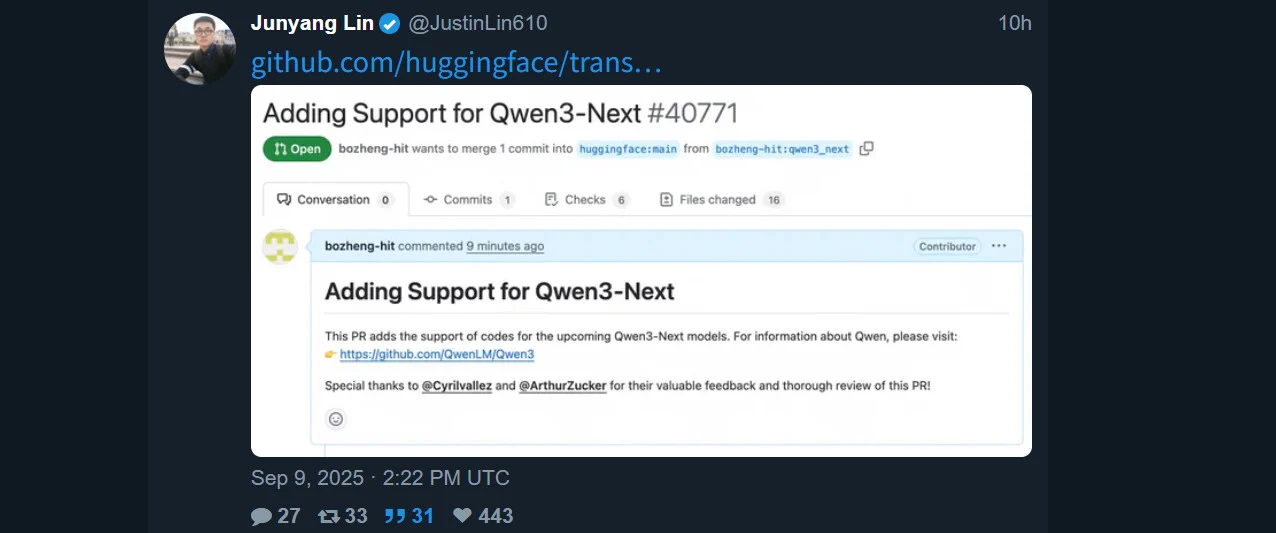

Adding Support for Qwen3-Next:https://github.com/huggingface/transformers/pull/40771

概述

Qwen3-Next 系列代表我们下一代基础模型,专为极端上下文长度和大规模参数效率优化。该系列引入了一套架构创新,旨在在最小化计算成本的同时最大化性能:

- 混合注意力:用 Gated DeltaNet 和 Gated Attention 的组合替代标准注意力,实现高效的上下文建模。

- 高稀疏 MoE:在 MoE 层实现极低的激活率,达到 1:50——大幅降低每个 token 的 FLOPs,同时保持模型容量。

- 多标记预测(MTP):提升预训练模型性能,并加速推理。

- 其他优化:包括零中心化和权重衰减层归一化、门控注意力等技术,以及其他用于稳健训练的稳定增强功能。

基于此架构,我们训练并开源了 Qwen3-Next-80B-A3B ——总参数量 80B,仅 3B 为活跃参数——实现了极致的稀疏性和效率。

尽管极其高效,它在下游任务中仍优于 Qwen3-32B——同时训练成本不到 1/10。此外,在处理超过 32K 标记的上下文时,其推理吞吐量比 Qwen3-32B 高出 10 倍以上。