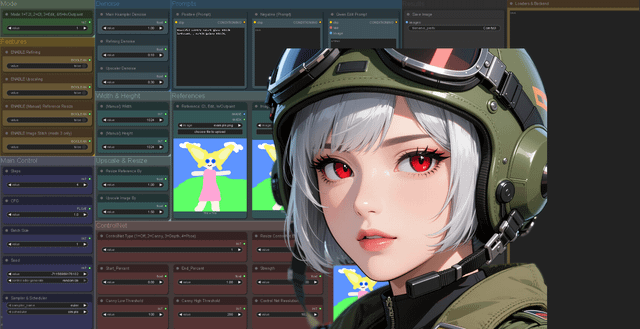

这是我之前那个Qwen驾驶舱工作流程的升级版,加了不少新功能,也做了一些优化。和第一版一样,理念还是那个理念 —— 把ComfyUI那些复杂的部分都去掉,留下一个干净、易读、完全模块化的工作流程。</br>

所有加载器我都挪到后端去了,包括Lora加载器,你只需要把后端折叠起来就能看到它们。你可以在下面这个链接访问Qwen工作流程。我也把它适配成了SDXL版本,点这里就能找到。</br>

当前流程包括:</br>

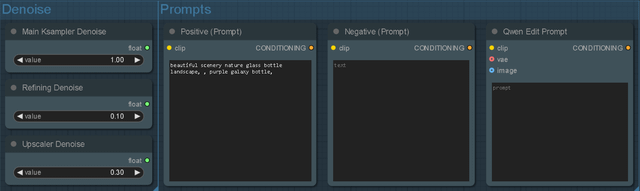

文字生成图片</br>

图片生成图片</br>

Qwen编辑模式</br>

修复(Inpaint)</br>

扩图(Outpaint)</br>

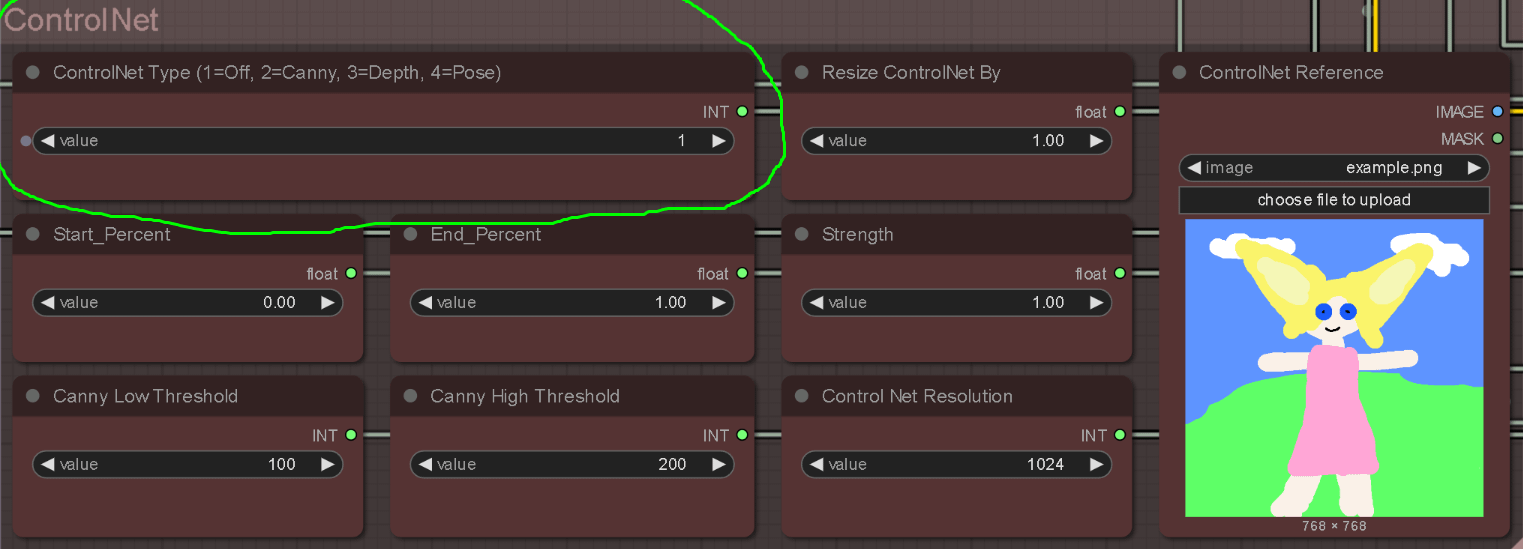

ControlNet</br>

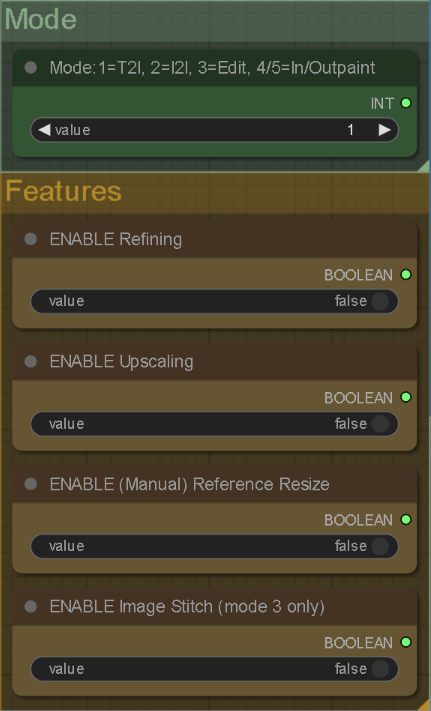

所有这些功能都由左上角的“模式”节点控制。你只需要切换到你需要的模式,整个流程就会自动适配。ControlNet稍微有点不一样,它是和所有模式并行运行的,所以你可以在任何流程中启用它,只需要通过“类型”节点来选择对应的ControlNet模型。</br>

包含的功能有:</br>

精炼(Refine)</br>

放大</br>

调整尺寸</br>

图像拼接(Image Stitch)</br>

这些功能和之前一样,只要启用你需要的那个,它就会自动应用。图像拼接是新增的功能,目前只适用于模式3(Qwen Edit),因为它可以让你在已有图片里添加对象或者人物。</br>

我在自己8G显存的3070上测试了所有功能,都能正常运行。使用的是Lightning 4步Lora,基础生成时间大概在2025秒左右,这也是当前流程的默认配置。</br>

如果你在使用过程中遇到任何问题或者错误,欢迎随时告诉我,我会尽快修复。再次感谢你的支持,希望你喜欢这个工作流程!</br>         |