尽管名称如此,逻辑回归是一种 监督学习算法,主要用于 分类,而非回归。它预测一个具有两种可能结果(二元分类)的分类目标变量。这些结果通常用二进制值表示(如 0 或 1、真或假、是或否)。

例如,逻辑回归可以预测一封电子邮件是否是垃圾邮件,或者客户是否会点击广告。该算法使用逻辑函数对目标变量属于特定类别的概率进行建模,该函数将输入特征映射为介于 0 和 1 之间的值。

什么是分类?

在深入研究逻辑回归之前,让我们先弄清楚机器学习中 分类的含义。分类是一种监督学习,旨在将数据点分配到特定的类别或类别中。与预测连续值的回归不同,分类预测的是离散标签。

分类问题的例子包括

- 识别诈骗交易(诈骗或非诈骗交易)

- 动物图片分类(猫、狗等)

- 根据患者症状诊断疾病(疾病存在或不存在)

在所有这些情况下,我们所期望的输出都是一个类别或标签。

逻辑回归的工作原理

与输出连续值的线性回归不同,逻辑回归输出的是介于0到1之间的概率分数。这个分数代表输入属于正类(通常表示为'1')的可能性。

为此,它采用了一个 sigmoid 函数,将任何输入值(特征的线性组合)映射到 0 到 1 范围内的一个值。该函数引入了非线性,允许模型捕捉特征与结果概率之间的复杂关系。

什么是Sigmoid函数?

Sigmoid函数是一种数学函数,它将任何输入值(范围从负无穷大到正无穷大)映射到0到1之间的输出值。这使得它在建模概率方面特别有用。

Sigmoid 函数具有独特的 "S "形,因此得名。开始时,负输入值较低,然后在零点附近迅速上升,最后在正输入值较高时趋于平稳。这种在 0 和 1 之间平滑、渐进的过渡使它能够表示事件发生的概率。

在逻辑回归中,sigmoid 函数将输入特征的线性组合转换为概率分数。这个分数代表输入属于正类的可能性。

Sigmoid 函数

Sigmoid 函数的数学表示法是

P(x) = 1 / (1 + e^-z)

Python

P(x) 是预测概率。e 是自然对数的底数(约为 2.718)。- z

是输入特征及其权重的线性组合,类似于线性回归方程:z = m1x1 + m2x2 + ... + mnxn + c

垃圾邮件检测

假设我们正在使用 逻辑回归构建一个垃圾邮件过滤器。该算法将分析电子邮件的各种特征,如发件人地址、某些关键词的存在以及电子邮件的内容,从而计算出一个概率分数。如果得分超过预定义的阈值(如 0.8),则该电子邮件将被归类为垃圾邮件。

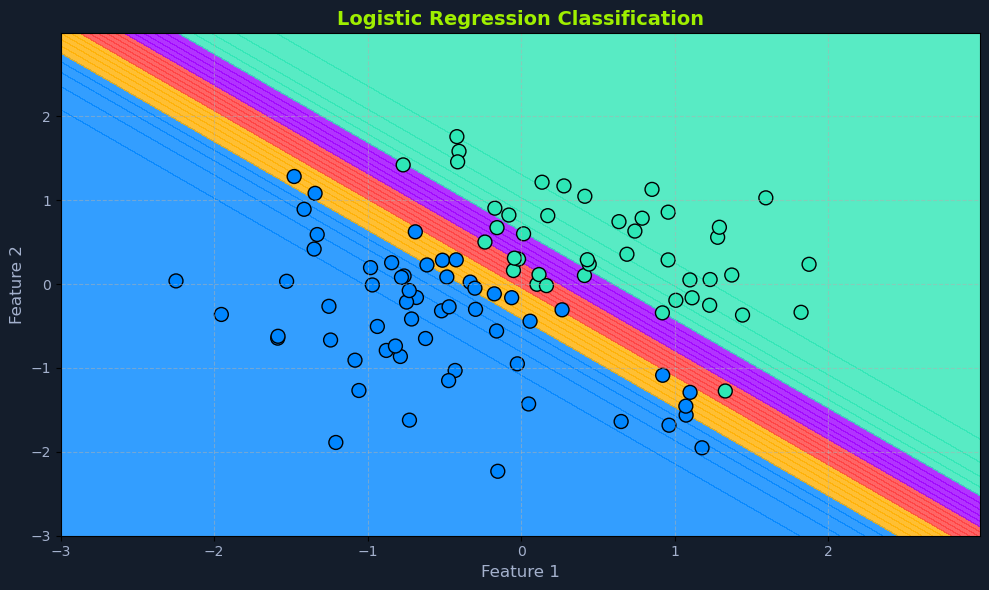

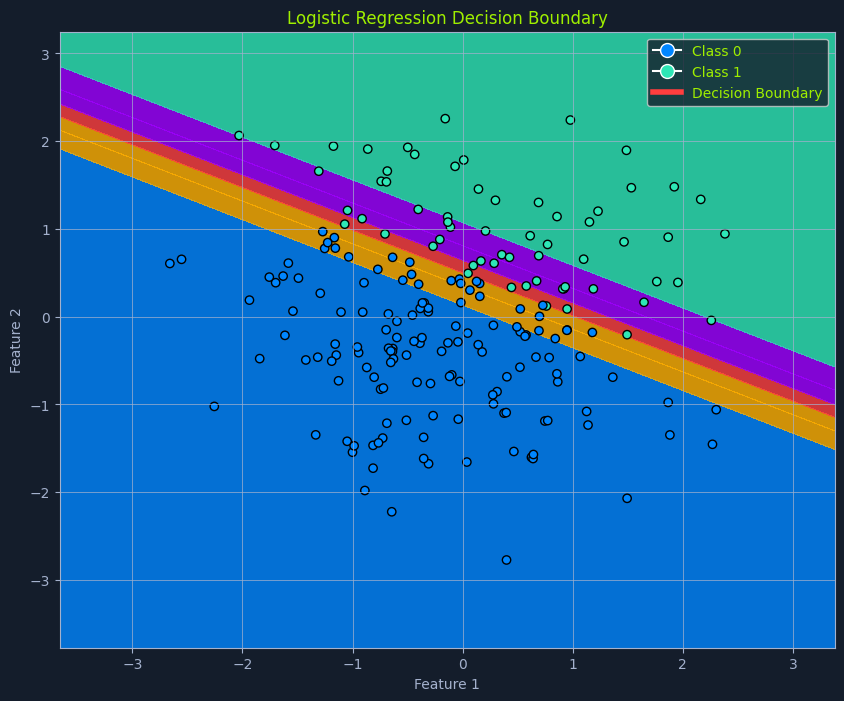

决策边界

逻辑回归的一个关键特性是 决策边界。在有两个特征的简化场景中,想象一条线将数据点分成两类。这条分隔线就是 决策边界,由模型的学习参数和选择的阈值概率决定。

在具有更多特征的更高维度中,这个分隔线会变成一个超平面。决策边界定义了将一个实例划分为一个类别或另一个类别的临界点。

了解超平面

在机器学习中,超平面是一个子空间,其维度比环境空间的维度小一个。这是一种在更高维度上可视化决策边界的方法。

可以这样想:

- 平面是二维空间(如一张纸)中的一条线,它将空间划分为两个区域。

- 超平面是三维空间(比如你的房间)中的一个平面,它将空间分成两半。

移动到更高的维度(三个以上的特征)会使可视化变得困难,但概念是相同的。超平面是一个 "平面 "子空间,它将高维空间划分为两个区域。

在逻辑回归中,超平面由模型的学习参数(系数)和所选阈值概率定义。它作为决策边界,根据预测概率将数据点分成不同的类别。

阈值概率

阈值概率通常设置为 0.5,但也可根据具体问题以及真假阳性之间的平衡进行调整。

- 如果给定数据点的预测概率

P(x) 高于阈值,则该实例被归类为正类。

- 如果

P(x) 低于阈值,则被归为负类。

例如,在垃圾邮件检测中,如果模型预测一封邮件有 0.8 的概率是垃圾邮件(而阈值是 0.5),那么这封邮件就会被归类为垃圾邮件。如果将阈值调整为 0.6,则需要更高的概率才能将邮件归类为垃圾邮件。

数据假设

逻辑回归虽然不像 线性回归那样严格,但也有一些关于数据的基本假设:

二元结果: 目标变量必须是分类变量,只有两种可能的结果。对数赔率的线性关系: 它假定预测变量与结果的对数赔率之间存在线性关系。对数赔率是概率的一种转换,表示赔率比(事件发生的概率除以不发生的概率)的对数。没有或几乎没有多重共线性:理想情况下,预测变量之间应该几乎没有多重共线性。多重共线性发生在预测变量高度相关时,这使得难以确定它们对结果的单个影响。大样本量: 逻辑回归在较大的数据集上表现更好,可以进行更可靠的参数估计。

在应用逻辑回归之前评估这些假设有助于确保模型的准确性和可靠性。数据探索、可视化和统计测试等技术可用于评估这些假设。